什么时候会用到 Parquet ?

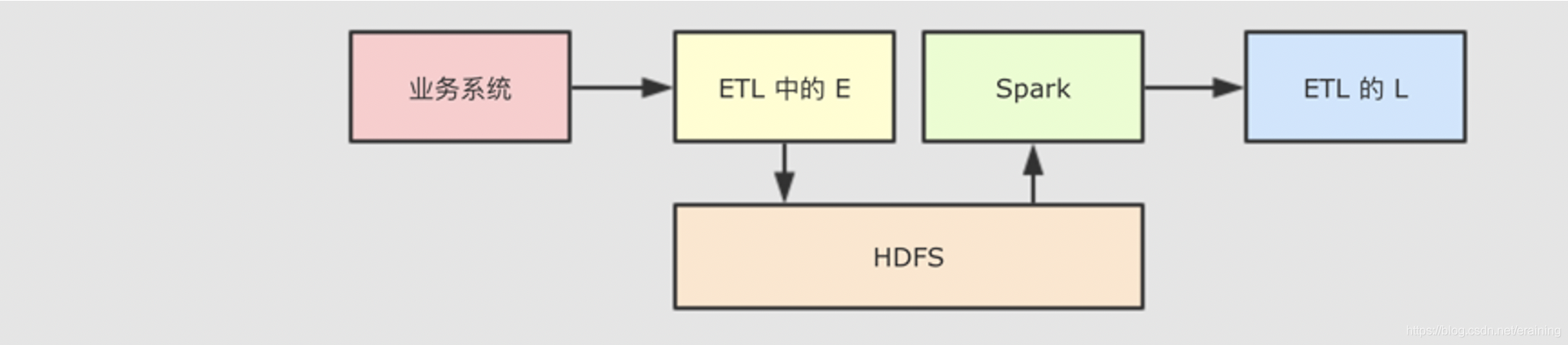

- 在 ETL 中, Spark 经常扮演 T 的职务, 也就是进行数据清洗和数据转换.

- 为了能够保存比较复杂的数据, 并且保证性能和压缩率, 通常使用 Parquet 是一个比较不错的选择.

- 所以外部系统收集过来的数据, 有可能会使用 Parquet, 而 Spark 进行读取和转换的时候, 就需要支持对 Parquet 格式的文件的支持.

使用代码读写 Parquet 文件

默认不指定 format 的时候, 默认就是读写 Parquet 格式的文件

import org.apache.spark.sql.{ DataFrame, SparkSession热门文章

- 宠物粮食品牌前十名排行榜图片及价格大全集(宠物粮食品牌起名大全)

- C ++程序实施Rabin-Miller素性测试以检查给定数字是否为素数

- VPN美国 | 3月9日20.8M/S|免费VPN/SSR/V2ray/Shadowrocket/Clash免费节点链接地址

- Java的ArrayList用法

- VPN美国 | 3月27日22.3M/S|免费VPN/V2ray/Clash/SSR/Shadowrocket免费节点链接地址

- VPN美国 | 4月7日20.2M/S|免费VPN/V2ray/Shadowrocket/SSR/Clash免费节点链接地址

- VPN美国 | 3月18日19.1M/S|免费VPN/Clash/Shadowrocket/SSR/V2ray免费节点链接地址

- Kafka消费者rebalanced异常分析

- JVM程序计数器与虚拟机栈

- spring boot web项目